Как узнать, что сайт под фильтром поисковиков и как выйти из под фильтра

Поисковые роботы не мыслят человеческими категориями, у них своя машинная логика. Поэтому каких-то деталей мы можем не понять или не заметить. Например, SEO-специалисту кажется, что он все делает правильно, а позиции сайта проседают и проседают. Или, наоборот, резко обрушиваются на десятки пунктов. Возможно, проблема в том, что сайт закрыли фильтром.

Коротко о фильтрах

Фильтры — это форма санкции. Их накладывает поисковый робот за попытку продвинуть сайт против его правил и алгоритмов. Таких правил очень много, и они регулярно обновляются. Так что сделать все правильно с первого раза и никогда не подвергаться наказаниям — большая удача.

Поисковики заинтересованы в том, чтобы пользователям было комфортно, а сайты размещали полезный и релевантный контент. В этом — назначение фильтров.

Наказывают поисковые системы двумя видами санкций — пессимизацией и блокировкой. Пессимизация означает, что сайт опустится ниже на странице выдачи, а блок — что доступ к ресурсу, очевидно, будет перекрыт.

Со вторым вариантом разобраться сложнее, и это уже тема для другой статьи. Поэтому здесь мы расскажем о том, как проверить, попал ли сайт под фильтр Яндекса или Гугла.

Вот самые популярные фильтры поисковых роботов:

- АГС — не пропускает к выдаче сайты, которые манипулируют методами оптимизации. Например те, которые нескромно размещают ключи списком.

- Минусник у Яндекса и Пингвин у Гугла — ограничивают в ранжировании те сайты, которые за деньги размещают SEO-ссылки на площадках-посредниках. Таким способом администраторы добиваются более высокой авторитетности их ресурса.

- Переспам — наказывает сайты за нерелевантный контент.

- Кликджекинг / криптоджекинг — фильтры накладывают на площадки, которые накручивают действия пользователей / тайно майнят на сайте криптовалюту

- Назойливая реклама — пессимизирует сайты, которые раздражают пользователей ненужной им рекламой.

«Точно под фильтром»: какой контент попадает под санкции

Нарушений, из-за которых Яндекс или Google может наложить фильтры, достаточно много. Мы подготовили античек-лист, пройдясь по которому вы сразу увидите признаки «плохого» сайта, подверженному фильтрам.

- Переоптимизация. Вы добавили слишком много ключевых слов, дорвеев или переборщили с другими методами выведения сайта в топ. Контент из-за этого стал слишком искусственным.

- Бесполезная информация. Сюда относятся неуникальные статьи, переписанные с чужих площадок, их нерелевантное содержание и в целом дилетантский подход к контенту. На таких сайтах пользователь не находит ответов на его вопросы и быстро закрывает вкладку со страницей. Алгоритм воспринимает сайт как бесполезный и санкционирует его.

- Сокрытие информации от поискового робота. Звучит как уголовное преступление, но наказывают за это лишь пессимизацией — то есть, понижением в поисковой выдаче. Например, администраторы могут скрывать от поисковиков навязчивы рекламные баннеры. Роботы их не приветствуют, поэтому опускают позиции сайта. Но баннеры — источник дохода, поэтому владельцы домена маскируют их от краулеров.

- Контент 18+. За это наказывают не только поисковики.

- Спам-ссылки. Размещая ссылку на свой сайт на низкопробных ресурсах — например, с низким индексом цитирования или на ссылочной бирже — вы рискуете попасть под фильтр. Поисковые роботы воспринимают эту тактику как нечестную попытку завысить авторитет площадки. Так что прежде, чем размещать ссылку на каком-либо стороннем сайте, проверьте его уровень заспамленности: показатель не должен превышать 10%. Для этого есть сервисы checktrust.ru, sbup.com или xtool.ru.

- Неуникальные описания страниц. Иначе эти описания называются сниппеты, а еще Title и Description. Это те несколько строчек, которые человек видит на странице выдачи перед тем, как перейти на ресурс. Создавать уникальные тайтлы можно с помощью генератора, например, WebMasta.org.

- Агрессивная реклама. Тренд на мягкое и нативное вовлечение появился не просто так. Пользователей раздражают навязчивые баннеры, которые закрывают контент или по-другому мешают получить информацию, за которой человек и пришел. А поисковые системы ориентируются на пользователя.

- Имитация поведенческих факторов. Это подделка действий потенциального клиента — кликов, проведенному на сайте времени и пр. Когда на сайте резко и нетипично растет количество заказов, покупок и даже возвратов, поисковые роботы распознают такой скачок как подозрительный.

- Вирусы. Кроме комфорта роботы заботятся о безопасности пользователей. Так что такому сайту дорога только на изоляцию от поиска.

Если замечаете, что ваш сайт страдает каким-то из этих симптомов, — самое время их устранить, и тогда проблема решится быстро.

Главное — понять, за что вас наказали. Например, если проблема в переоптимизации, то объем этой самой оптимизации надо снизить: переписать статьи, разбавить их мультимедийным контентом, избавиться от лишних ключевых слов.

Для более неочевидных ситуаций мы собрали 6 способов, с помощью которых можно проверить сайт на фильтры Яндекса и Google. Так вы узнаете, присутствуют ли на них нарушения алгоритмов.

В каких источниках искать проблему

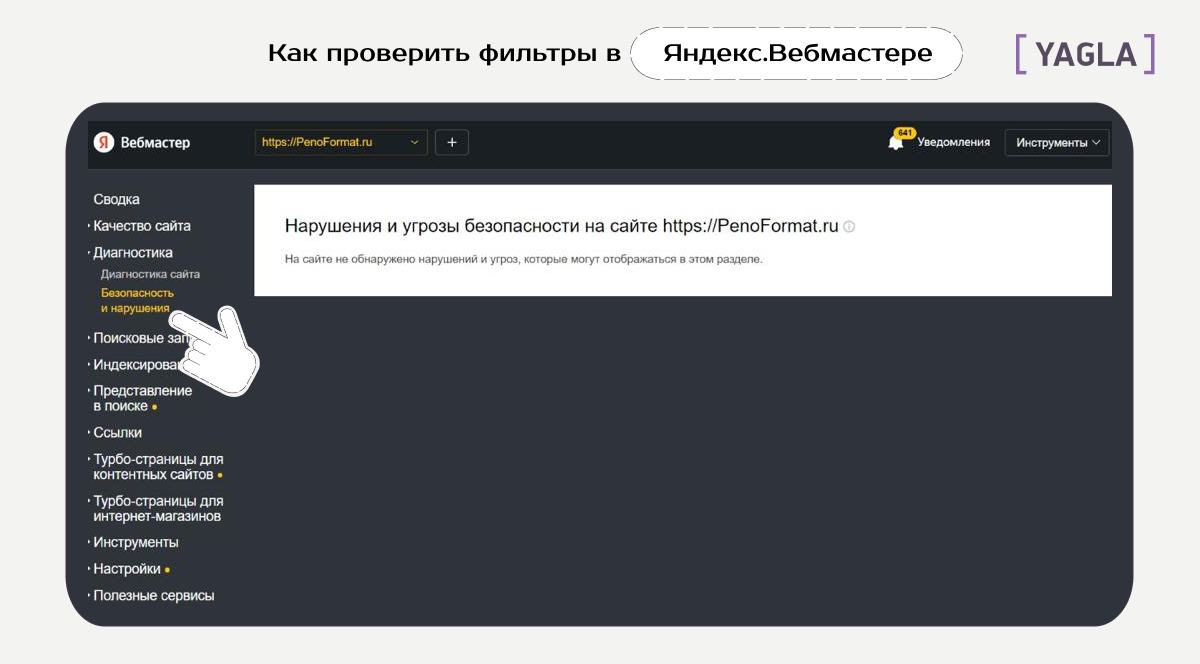

Проверка через панели веб-мастеров

Чтобы избавить администратора от рутинной работы, поисковые системы разработали онлайн-консоли для управления сайтом. Это — всем известные Google Search Console и Яндекс.Вебмастер.

Сервисы помогают оценивать индексацию, настраивать сниппеты, отслеживать статистику. Данные Яндекс.Вебмастера — это проекция всех позиций сайта в Интернете. Динамика показателей наглядно выражена на графиках, что позволяет быстро сделать выводы.

Кроме статистики Яндекс.Вебмастер и другие подобные консоли показывают проблемы с безопасностью. Сюда, в том числе, относится наложение санкций.

Чтобы проверить сайт на наличие фильтров Яндекса, перейдите в секцию «Диагностика», а после — в раздел «Безопасность и нарушения». Если проблема есть, вы увидите уведомление «Обнаружены проблемы с безопасностью».

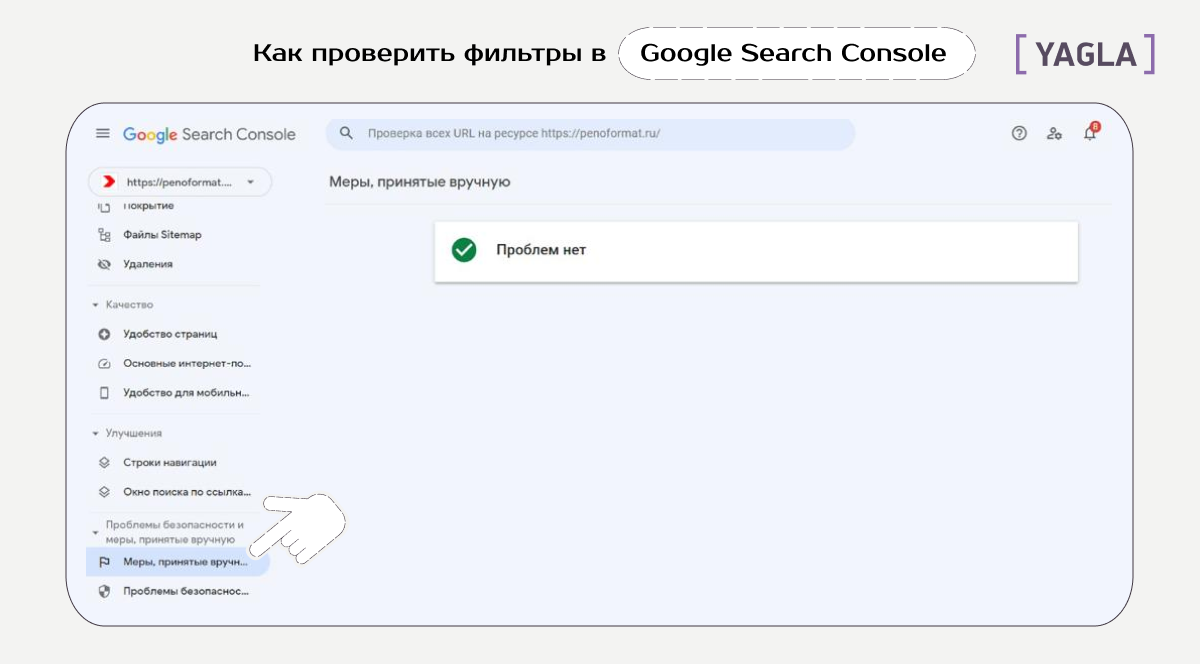

Для Google Search Console порядок действий такой: сперва перейдите в секцию «Проблемы безопасности и меры, принятые вручную», а далее — в раздел «Меры, принятые вручную». Результат вы увидите на белой панели справа.

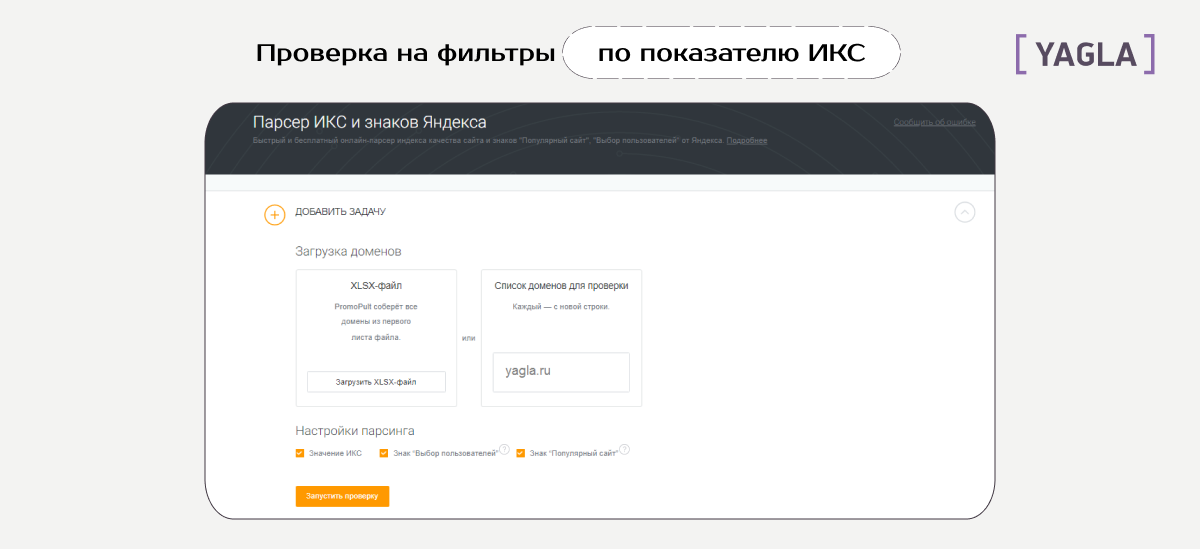

Проверка с помощью Индекса Качества Сайтов, или ИКС

ИКС показывает охваты — количество уникальных просмотров сайта, — глубину просмотра и среднее время, проведенное на ресурсе. То есть, этот индекс — индикатор того, насколько ваш контент интересен людям.

Значение Индекса Качества Сайтов определяется по нарастанию:

- 0-10 — низкий

- 10-50 — чуть выше минимума

- 50-500 — средний

- 500-2000 — хороший

- 2000 и выше — лучший ❤️

Поисковые роботы присваивают сайтам тот или иной ИКС в зависимости от качества и полезности контента, а за несоблюдение правил могут применить санкции. Соответственно, падение ИКС — признак того, что сайт находится под фильтром Яндекса или Гугла.

Проверить ИКС можно несколькими способами, в том числе — через панель вебмастера. Другой вариант — сервис PromoPult. Для генерирования результата он использует парсинг, что обеспечивает на выходе точные данные.

Чтобы проверить сайт, зарегистрируйтесь и вбейте домен вашего сайта в соответствующее поле. Проверка быстрая и бесплатная, а результаты вы получите в файле формата XLSX.

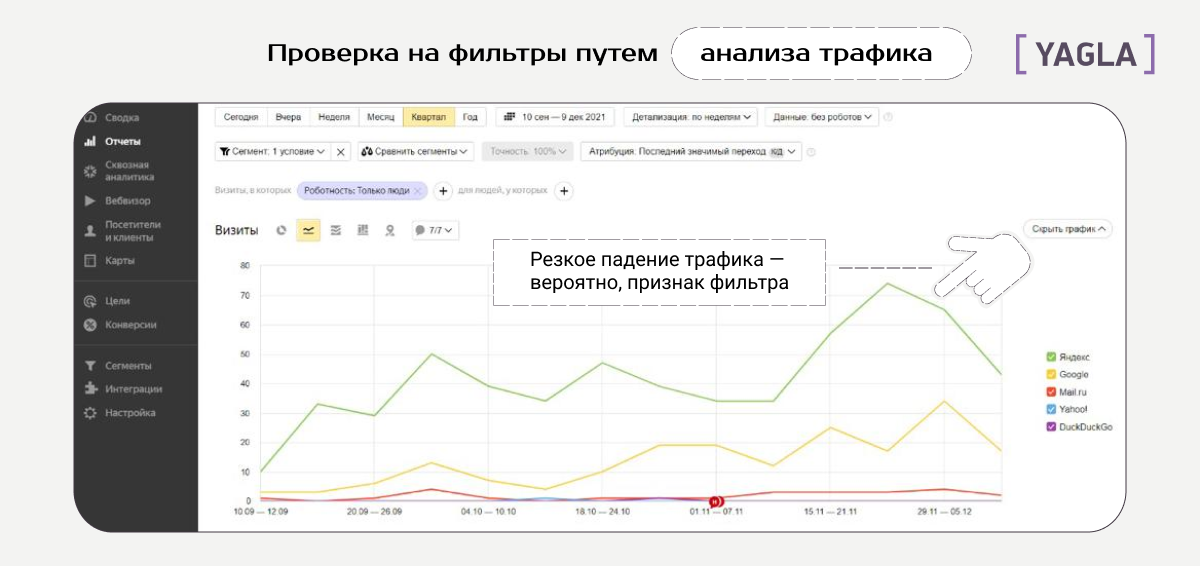

Проверка через анализ трафика на Яндекс.Метрике или в Google Analytics

Если Яндекс.Вебмастер показывает, как дела у сайта с поисковыми роботами, то Яндекс.Метрика — это отображение опыта пользователей в коммуникации с вашим сайтом. Если люди вдруг перестают посещать ваш ресурс, одна из возможных причин — в том, что они его не видят. А это уже может быть следствием того, что на сайт наложили санкции.

Диаграмма, на которую стоит обратить внимание при поиске фильтров — динамика трафика. Когда кривая круто падает вниз, это может быть признаком фильтра.

Падение трафика — не стопроцентное доказательство того, что на сайт наложили фильтр. Возможно, проблема в упавшем качестве контента: перегорел ваш копирайтер, и ему нужен отпуск.

Анализируйте трафик с опорой на специфику сайта и не забывайте про праздничные дни. Например, на сайте Yagla трафик в январе сильно падает, потому что в это время людям не до учебы. При этом на сайте emotionalrating.com, где можно подобрать фильм под настроение, количество посещений вырастет. Выходные и праздничные дни — самое то, чтобы смотреть фильмы.

Если вы это заметили, продолжайте анализ, комбинируя разные методы проверки. На пересечении нескольких подходов к поиску проблемы она будет идентифицирована с куда большей вероятностью.

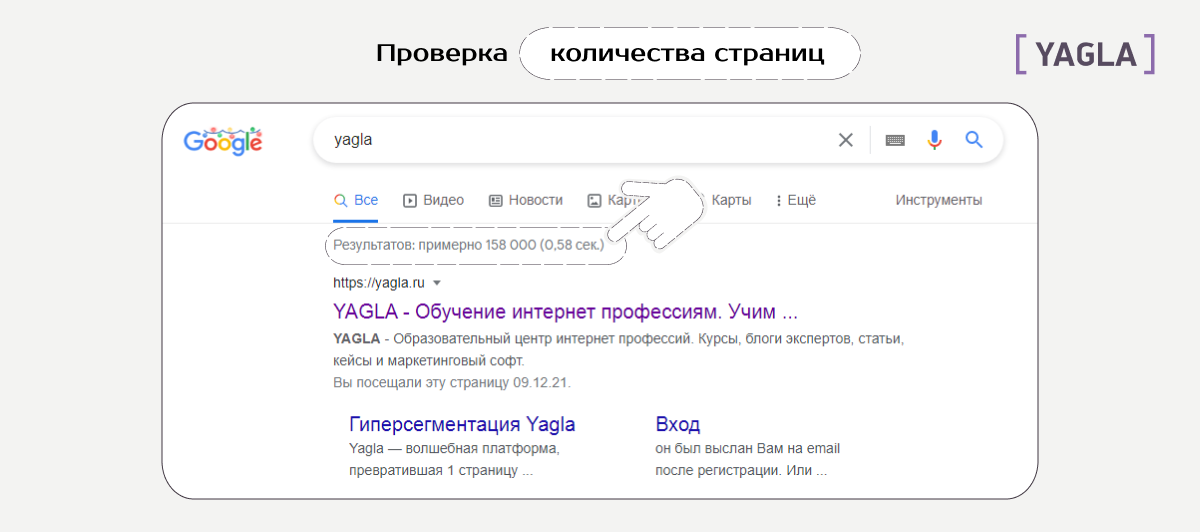

Проверка на изменение количества страниц в результатах поиска

Под санкции может попасть только часть контента сайта — то есть, отдельные его страницы. Если они не соответствуют правилам, поисковая система не пропустит их к выдаче.

Чтобы проверить, все ли страницы отображаются в результатах поиска, введите адрес сайта в поисковой строке Гугла по формуле site:<ваш домен>.ru. Обратите внимание на цифры под строкой: если страниц стало гораздо меньше, то сайт, вероятно, попал под фильтр.

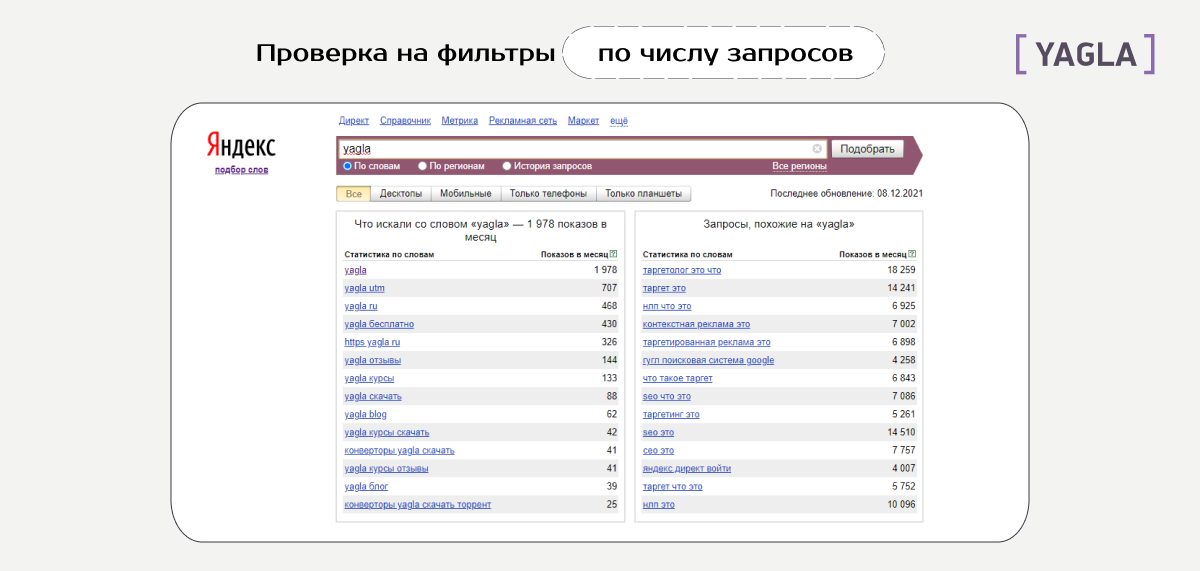

Выдача Яндекса не показывает количество результатов по запросу, но частоту тех или иных «загугленных» фраз можно отслеживать в сервисе Яндекс.Вордстат. Он показывает, какие сайты искали люди, используя указанные вами слова. Анализ можно ограничить параметрами времени и региона.

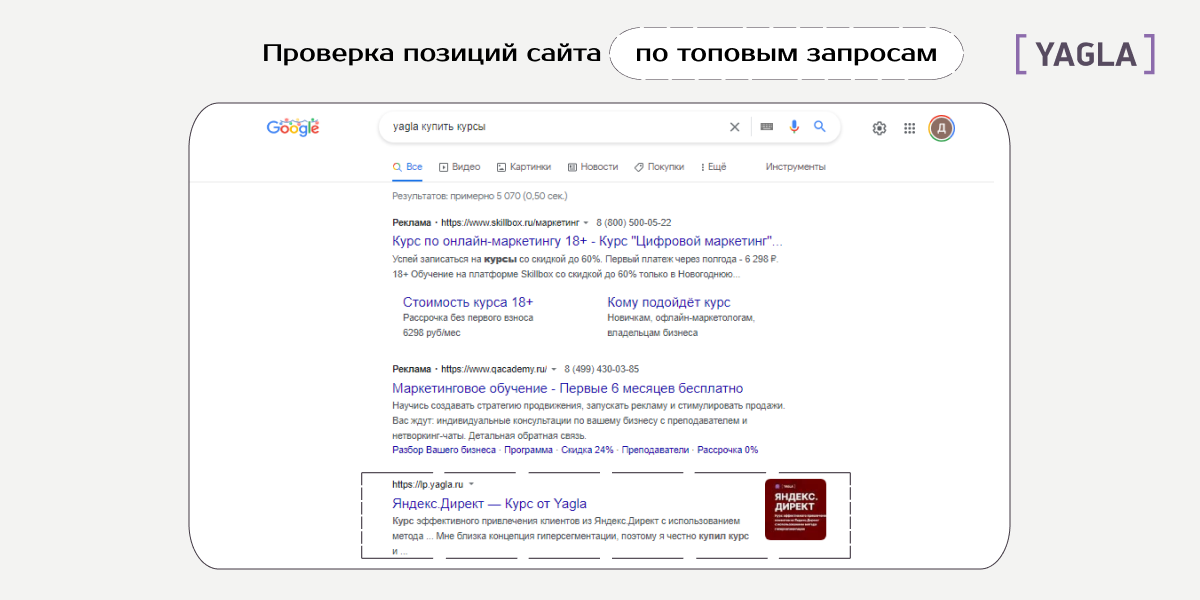

Проверка по самым популярным запросам

Этот метод работает, если вы применяете его регулярно. Суть том, чтобы в сравнении позиций сайта в поисковой выдаче через равные отрезки времени. Сильное падение «высоты» в результатах поиска может означать, что на сайт наложили санкции.

Выведите топ запросов, по которым пользователи чаще всего ищут ваш сайт. По этим формулам устраивайте периодические проверки в поисковиках — например, раз в две недели.

Когда вы начнете мониторить, на каком месте сайт отображается в выдаче, то легко заметите падение в ранжировании. То же самое можно проделать с брендом. Вбивайте его имя в поисковую строку и следите за тем, на каком месте в выдаче он отображается. Игнорируйте рекламную выдачу — эти позиции проплачены и к органической выдаче не относятся.

Делегирование проверок сервисам

Многие методы проверки можно автоматизировать. Кроме Я.Вебмастера и Я.Метрики используйте сервисы Barracuda, Fruition, SeoLib и Penalty.

Делегирование рутинных задач экономит время и снимает ответственность — на тот случай, если вы вдруг что-то упустите. Но отказываться от ручных методов тоже не стоит — будет надежнее, если во главу контроля станете вы, а не машина.

Что мы рекомендуем

#Прощевсего изначально вести сайт так, чтобы его контент сразу соответствовал всем требованиям поисковиков. Но иногда допускать ошибки не страшно, даже если на первый взгляд вы все делаете как надо.

Изучайте алгоритмы и обновляйте знания. Сочетайте разные методы проверок, работайте вручную и в меру доверяйте автоматическим сервисам. Когда мониторинг фильтрации превратится в налаженную систему, устранить любую проблему будет легко.

Как подготовить и оптимизировать сайт под мобильный трафик с PPC-рекламы Статья

Яндекс.Вебмастер: инструкция по применению Статья

Всё, что нужно знать про новые типы целей в Яндекс.Метрике Статья

Как удалить отзыв на Яндекс Картах? Статья

Проверяем, есть ли монетизация контента на Рутубе на 2024 год Статья

Как увеличить вовлеченность аудитории в социальных сетях Статья

Увеличили органический трафик в 9,7 раз при помощи блога: кейс платформы для работы с самозанятыми Qugo Статья

Клубы по подписке: в чём фишка и как их продвигать в VK Статья

Контекстная реклама в строительной нише: особенности работы и лайфхаки Статья